Investigadores del Instituto de Ciencias Biológicas de la Universidad de Toulouse (Francia) han utilizado la Inteligencia Artificial (IA) para descifrar la actividad cerebral registrada en imágenes por resonancia magnética funcional (FMRI) y reconstruido esas imágenes, vistas o imaginadas por personas, en una red neuronal artificial.

Utilizaron una técnica de IA conocida como aprendizaje profundo para entrenar una red de neuronas artificiales a representar más de 200.000 caras de una base de datos de celebridades.

El aprendizaje profundo es una técnica que imita la forma de aprendizaje humano utilizando algoritmos. Desarrolla otra forma de inteligencia artificial conocida como aprendizaje automático en la medida que incorpora complejidad al aprendizaje mecanizado.

Las caras representadas en la red neuronal artificial tenían 1.024 expresiones diferentes, como diferentes niveles de sonrisa, cejas, colores de la piel, género, con las cuales la red artificial podía crear nuevas caras.

Los investigadores recurrieron una nueva técnica de IA, la Red generativa antagónica (GAN), capaz de generar rostros de personas que no existen, para conseguir la multiplicación de las caras originales presentadas a la red neuronal artificial.

GAN es capaz de esta proeza porque emplea dos redes neuronales para contrastar datos almacenados en ambas redes y generar a partir de esta combinación de información, caras con perfiles reales, ajustadas a los modelos originales.

Dos redes neuronales comparadas

En esta investigación, GAN permitió a los investigadores comparar dos redes neuronales diferentes: una era la red neuronal correspondiente a los voluntarios participantes en la investigación, y la otra red neuronal era la red artificial que tenía almacenadas las 200.000 caras originales con 1.024 expresiones diferentes.

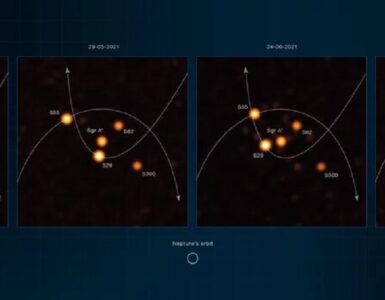

El acceso a la red neuronal biológica lo obtenía GAN a través de las imágenes de la actividad cerebral obtenida de los voluntarios mediante FMRI, que muestra imágenes de las regiones cerebrales activas al ejecutar una tarea determinada (ver una cara en este caso).

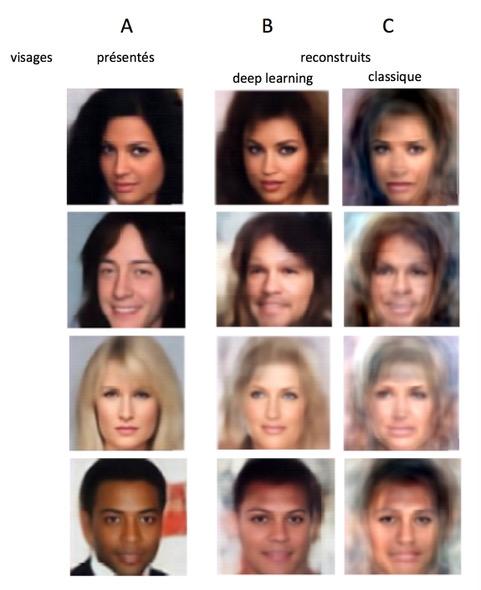

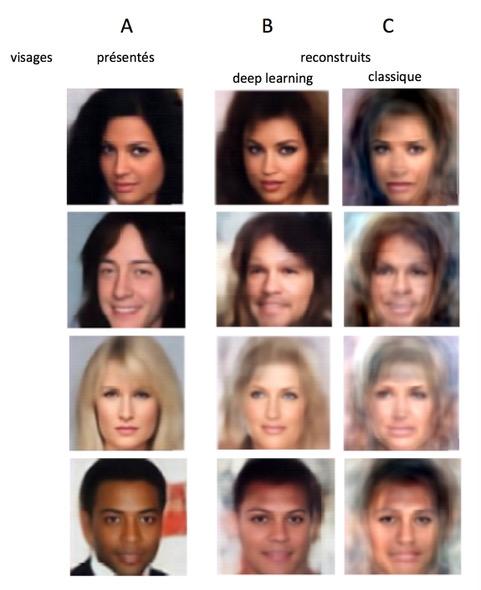

El sistema pudo comparar las imágenes de más de 8.000 caras presentadas a los voluntarios en el experimento, con las imágenes de caras representadas en la red neuronal artificial. A continuación, tradujo los patrones FMRI de los cerebros humanos y replicó las caras que veían los sujetos.

El resultado fue sorprendente: las caras replicadas por la red neuronal artificial fueron reconocibles en más del 95 por ciento de los casos, superando la fiabilidad de modelos anteriores de reconstrucción de caras, que era del 85 por ciento.

Una aportación adicional y no menos significativa de esta investigación es que ha permitido especificar las áreas del cerebro humano implicadas en el tratamiento de caras y, más particularmente, el tratamiento de género, que se sitúan en las zonas occipital y temporal.

También la imaginación

Otro resultado relevante es que el sistema fue capaz de reconstruir caras aunque los voluntarios de la investigación no estuvieran viendo ninguna, sino solo imaginándola. En este caso, la fiabilidad de la red neuronal artificial fue del 80 por ciento.

Los investigadores destacan en un comunicado que este sistema de IA, que puede leer y comprender la información sensorial presente en el cerebro, ayudará a resolver muchas cuestiones pendientes en neurociencia sobre el tratamiento neuronal de las caras.

Consideran asimismo que este modelo de aprendizaje profundo de la IA puede compararse con las representaciones que realiza el cerebro humano para aprender, que usa la abstracción (concepto de cara) para construir conocimiento (nuevas caras) a partir de un concepto precedente.

Añaden que descifrar información sensorial a partir de la actividad cerebral es un gran desafío tecnológico y un tema fundamental para la neurociencia del siglo XXI, y que su investigación representa un hito en este recorrido.

Mientras que en los últimos 15 años, los modelos clásicos han sido capaces de decodificar de manera confiable actividad cerebral sobre objetos pertenecientes a diferentes categorías (caras vs casa, por ejemplo), no han conseguido diferenciar objetos de la misma categoría (caras sonriendo vs cara triste, por ejemplo), una barrera que el nuevo trabajo ha superado.

Referencia

Reconstructing faces from fMRI patterns using deep generative neural networks. Rufin VanRullen, Leila Reddy. Communications Biology, Volume 2, Article number: 193 (2019). DOI: https://doi.org/10.1038/s42003-019-0438-y

Hacer un comentario