Los turistas confían en las guías para conocer de antemano puntos de interés en sus visitas. La mayoría relata hechos históricos interesantes e incluye descripciones específicas, pero puede resultar difícil visualizar totalmente la escena que presentan. Las imágenes que acompañan al texto suelen ser escasas, lo que no favorece esa comprensión de las relaciones espaciales entre cada punto de vista de la imagen.

Quienes optan por plataformas web como Wikipedia para documentarse tampoco lo tienen mucho más fácil. A pesar de no tener restricciones de espacio, estos sitios también pecan de limitada y desconectada cobertura visual. Las fotos quedan relegadas más bien a una mera función ilustrativa.

Por contra, Bryan Russell de Intel Labs y sus colegas de la Universidad de Washington en Seattle, Estados Unidos, apuestan por mostrar una imagen interactiva junto al lugar descrito. Para ello han desarrollado el primer software capaz de crear automáticamente reconstrucciones 3D de monumentos.

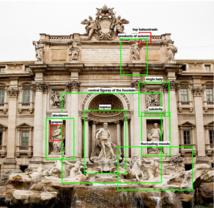

El sistema analiza textos contenidos en Wikipedia u otros sitios, junto con imágenes también online, para conseguir una recreación lo más fidedigna posible de enclaves de interés turístico, lo que permite una visita guiada mientras se consulta información, ya que al desplazarse por el artículo, cada vez que se menciona una característica reseñable se vincula con la zona correspondiente en el modelo tridimensional.

Unión de texto e imágenes

Según explican los investigadores en su estudio, el software realiza en primer lugar una búsqueda de imágenes en Flickr o Google con las que componer el modelo 3D, recreando la geometría completa del edificio o monumento. A partir de ahí analiza Wikipedia en busca de objetos de interés del enclave, tales como pinturas o estatuas, que va encajando perfectamente en el lugar apropiado de la reconstrucción.

En la búsqueda de imágenes, el sistema añade todas las palabras clave necesarias para afinar el resultado. Por supuesto, esta estrategia no siempre funciona, ya que la búsqueda puede devolver imágenes erróneas o sin calidad. Para solventarlo, el software utiliza técnicas de reconocimiento de objetos, con lo que filtra y verifica los resultados.

Hasta ahora la mayoría de técnicas de reconocimiento requieren una base de datos de objetos etiquetados como referencia. Por el contrario, el objetivo de Russell y su equipo es crear una base de datos fruto del análisis conjunto de texto e imágenes. Y es que la novedad del sistema no radica tanto en la recreación en sí, como en la capacidad para transformar automáticamente textos descriptivos como los de Wikipedia en experiencias visuales interactivas en 3D, donde las referencias escritas enlazan a modelos reconstruidos.

De hecho, la herramienta permite desde seleccionar el texto para mover la cámara hacia los objetos correspondientes, cuadros delimitadores en la imagen para regresar a la descripción, hasta una opción para sobrevolar de forma automática a través de la escena mientras se lee sobre ella.

Aunque la automatización del método no es perfecta, los investigadores han sido capaces de extraer con gran precisión muchos de los objetos de cada escena con relativamente pocos errores. Para ello los experimentos se llevaron a cabo en algunos de los enclaves turísticos más importantes del mundo.

Esto también influye, pues no todos los sitios están igual de referenciados en Internet. “La herramienta funciona muy bien con la Capilla Sixtina, pero no tanto con otros edificios que no están tan bien documentados”, destaca Rusell. Pese a ello se obtienen resultados de calidad, aunque en algunos casos no estén disponibles todos los objetos o escenas de la composición.

Aplicaciones

Si bien los resultados de la investigación son alentadores, los autores coinciden en que no existe mucho margen de mejora. Sólo optimizaciones de los algoritmos de reconstrucción en 3D o de los programas de análisis de texto podrían favorecer su aplicabilidad.

Según un artículo publicado en la revista New Scientist, el objetivo final del equipo sería crear una valiosa aplicación de realidad aumentada que se podría utilizar durante visitas a enclaves turísticos. “Con sólo mirar un objeto, una cámara portátil podría recuperar su punto de vista en relación con el modelo 3D, reconocerlo y ofrecer más información sobre el mismo”, vaticina Russell.

De los resultados de la investigación y de sus posibles aplicaciones se hablará el próximo noviembre en Siggraph, la renombrada feria de conferencias e exhibiciones de gráfica computacional e interactivos que este año se celebra en Hong Kong.

Pese a que el estudio lleva por título Wikipedia 3D y que se basa fundamentalmente en sus artículos, el sitio parece no tener planes inmediatos para incluir el método de visualización 3D. Al menos así lo asegura Fabrice Florin, jefe de producto de la Fundación Wikimedia, de la que depende Wikipedia, aunque reconoce que seguirá de cerca su progreso. “Estamos muy contentos de que los investigadores estén desarrollando nuevas formas de presentar el contenido de la Wikipedia y otros proyectos de Wikimedia», añade.

Hacer un comentario