Las personas ciegas a menudo sustituyen el sonido por la vista, y algunas pueden incluso recurrir a la ecolocalización, lo que les permite localizar y discriminar objetos por las ondas acústicas. Pero resulta que el sonido puede también adaptarse para transmitir información visual. Unos investigadores del Instituto de Tecnología de California (Caltech), en Estados Unidos, están aprovechando ese descubrimiento para ayudar a personas ciegas.

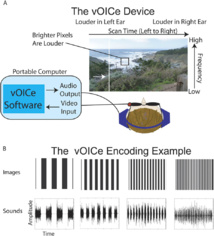

Para ello han desarrollado unas gafas inteligentes que convierten las imágenes en sonidos que los usuarios pueden entender de manera intuitiva y sin necesidad de entrenamiento. Según recoge un artículo publicado en la revista online NewScientist, el dispositivo llamado vOICe (OCI significa «¡Oh, I See!»), consta de un par de gafas oscuras con una pequeña cámara que se conecta a un ordenador. El sistema se basa en un algoritmo del mismo nombre desarrollado en 1992 por el ingeniero holandés Peter Meijer.

La herramienta es un ejemplo de cómo se integra la información percibida por diferentes sentidos para componer un todo. Así, por ejemplo, en una cocina, el cerebro procesa el sonido del aceite que chisporrotea, el aroma de las especias, la estética visual de los alimentos dispuestos en el plato, o el tacto y el gusto de tomar un bocado. Aunque todas estas señales pueden parecer distintas e independientes, en realidad interactúan y se integran dentro de la red cerebral de neuronas sensoriales.

Precisamente son esas conexiones neuronales preexistentes las que proporcionan un punto de partida importante para formar a personas con discapacidad visual en el uso de este tipo de dispositivos que les ayudarán a ver.

Una persona vidente simplemente tiene que abrir los ojos y el cerebro procesa automáticamente las imágenes y la información para que se produzca una interacción perfecta con su entorno. Sin embargo, los dispositivos actuales para ciegos y deficientes visuales no son tan automáticos o intuitivos, pues en general requieren concentración y la atención completa del usuario para interpretar la información sobre lo que le rodea.

Esta nueva perspectiva multisensorial podría facilitar tareas que antes requerían mucho tiempo, permitiendo a los invidentes la adquisición de una nueva funcionalidad sensorial similar a la visión.

Estimular la corteza visual

«La mayoría de libros sobre neurociencia sólo dedican unas páginas a la interacción multisensorial, mientras el 99 por ciento de nuestra vida cotidiana depende de este proceso», lamenta Shinsuke Shimojo, investigador principal del estudio, en un comunicado de Caltech.

A modo de ejemplo, explica que si una persona está hablando por teléfono con alguien que conoce muy bien y está llorando, aunque sólo pueda escuchar el sonido, es capaz de visualizar sus lágrimas en la cara. De esta forma demuestra que la causalidad sensorial no es unidireccional, pues la visión puede influir en el sonido, y viceversa.

Junto a su compañera Noelle Stiles han explotado este proceso para estimular la corteza visual con señales auditivas que codifican la información sobre el entorno. Para ello han utilizado asociaciones que cualquiera conoce, como relacionar un tono alto a lugares elevados en el espacio o sonidos ruidosos con luces brillantes.

El algoritmo de vOICe escanea cada imagen de la cámara de izquierda a derecha, y para cada columna de píxeles genera un sonido con una frecuencia y volumen que depende de la ubicación vertical y el brillo de los píxeles. De esta forma, muchos píxeles brillantes en la parte superior de una columna se traducirían en un sonido de alta frecuencia, mientras que píxeles oscuros en la parte baja darían lugar a un sonido más tranquilo, en un tono más bajo. Finalmente, unos auriculares envían el sonido procesado al oído del usuario, permitiéndole asociar diferentes sonidos a objetos y elementos de su entorno.

Los investigadores realizaron pruebas tanto con personas videntes como invidentes. A los primeros se les pidió emparejar imágenes (rayas, manchas, texturas) con sonidos sin ningún tipo de formación ni instrucciones previas, mientras que los invidentes debían tocar texturas y combinarlas con sonidos. Ambos grupos mostraron una capacidad intuitiva para relacionar texturas e imágenes con los sonidos asociados. Sorprendentemente, el rendimiento del grupo sin entrenamiento no difirió mucho de los preparados.

Conexiones preexistentes

El estudio, descrito en un artículo publicado en la revista especializada Scientific Reports, detectó que el uso de vOICe para ver texturas “ilustra conexiones neuronales intuitivas entre dichas texturas y los sonidos, lo que implica que hay conexiones preexistentes”, asegura Shimojo. Un ejemplo común de estas conexiones es la sinestesia, por la cual la activación de un sentido conduce a una experiencia sensorial diferente involuntaria, como ver un determinado color al oír un sonido específico.

Aunque aún no sabrían determinar lo que hace cada región sensorial del cerebro cuando procesa estas señales, tienen una idea aproximada. Para comprenderlo mejor están utilizando datos funcionales de resonancias magnéticas para analizar la red neuronal.

Más allá de sus implicaciones prácticas, la investigación plantea una importante pregunta filosófica: ¿Qué es ver? «¿Es ver lo que pasa cuando abres los ojos? No, porque eso no es suficiente si la retina está dañada ¿Es cuando se activa la corteza visual? Nuestra investigación ha demostrado que la corteza visual puede activarse por el sonido, lo que indica que realmente no necesitamos los ojos para ver”, se cuestiona Shimojo. Sea una cosa u otra, lo cierto es que con este tipo de aplicaciones se ofrece a los invidentes una experiencia visual a través de otros sentidos.

Hacer un comentario