La Unión Europea ha publicado recientemente información sobre el estado actual del llamado proyecto CASBliP, destinado a crear una tecnología que ayude a los ciegos a ser más independientes tanto en espacios abiertos como cerrados.

En este proyecto colaboran en total siete instituciones europeas: el Instituto Francesco Cavazza y la Federación Alemana de Ciegos y Videntes Parciales (DBSV) -dos grandes organizaciones de ciegos de Italia y Alemania-; la compañía Siemens; la Universidad de Bristol (Inglaterra) y la Universidad de La Marche (en Italia); y las universidades españolas de La Laguna y de la Politécnica de Valencia (UPV).

El proyecto CASBliP (acrónimo en inglés de Sistema Cognitivo de Ayuda a Personas Ciegas) ha sido desarrollado con fondos del Sexto Programa Marco de la Unión Europea, y fue inicialmente concebido para integrar el procesamiento de imágenes y las tecnologías de mapeo acústico en un solo dispositivo portátil.

En qué consiste

El sistema permite, básicamente, analizar las imágenes captadas por cámaras de video portátiles para, a partir de ellas, calcular la distancia de obstáculos, y predecir los movimientos de otros transeúntes y de coches.

La información recogida es transformada y posteriormente transmitida a los ciegos en forma de sonidos que serían representaciones acústicas de la realidad tridimensional que ellos no pueden ver.

Según publicó en febrero lasprovincias.es, esto se consigue combinando cuatro tecnologías concretas en un mismo dispositivo: el láser infrarrojo, imágenes de vídeo y dos aplicaciones de GPS.

Con esta combinación, las cámaras digitales se convierten en auténticos “ojos”, que permiten a los ciegos percibir los objetos y las actividades que se están desarrollando a su alrededor.

CASBliP por partes

Cada una de las partes necesarias para el dispositivo CASBliP ha sido desarrollada por diversas instituciones. Así, explica la web del proyecto, el Computer Vision Group de la Universidad de Bristol ha creado un casco auricular portátil que, a tiempo real, permite dar información acústica sobre su entorno a los invidentes, además de los algoritmos necesarios para la identificación de objetos y obstáculos.

Por otro lado, los científicos de la Universidad Politécnica de Valencia han trabajado en el desarrollo de modelos tridimensionales útiles en aplicaciones como la realidad virtual o la robótica.

Los investigadores de la Universidad de La Laguna crearon y probaron con éxito un sistema que representa los espacios captados por las cámaras como mapas acústicos, y la Universidad de Marche, en Italia, desarrolló un sensor giroscópico que detecta cómo mueve el usuario la cabeza, de manera que los sonidos que éste reciba den una información acorde con su posición.

Finalmente, Siemens desarrolló un sensor CMOS capaz de obtener información tridimensional de las distancias a tiempo real.

Con todo esto, el nuevo dispositivo permite al que lo lleva identificar objetos y obstáculos, como árboles, mobiliario urbano, vehículos o transeúntes. Asimismo, genera todo el tiempo un “mapa con profundidad” para calcular las distancias y analiza los a personas y objetos en movimiento, prediciendo hacia dónde se están desplazando.

Escuchar el espacio

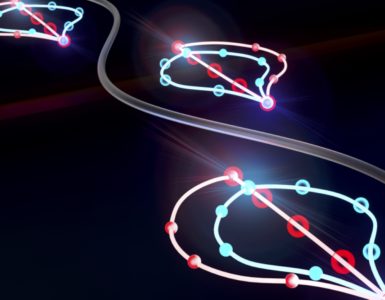

Evidentemente, la información visual recogida no puede ser presentada como tal a los usuarios del CISBliP. Por eso, la Universidad de La Laguna, en Tenerife, ha desarrollado una tecnología que hace posible transformar dicha información espacial en mapas acústicos que reflejan tres dimensiones.

Con los auriculares del CISBliP puestos, los ciegos pueden oír cómo cambia el sonido a medida que se mueven. El sistema audio en estéreo posibilita modificar los sonidos, de manera que el cerebro pueda interpretarlos como puntos en el espacio.

Así, si la persona que lleva el dispositivo se acerca caminando hacia cualquier objeto, el sonido aumenta. Al contrario, cuando la persona se aleja de las cosas o personas captadas por las cámaras, el sonido se hace más bajo.

Por otro lado, los objetos situados a la derecha del usuario se “escuchan” a la derecha, y si el usuario mueve la cabeza, el sonido se mueve también para que el invidente pueda localizar las cosas o a las personas según su propia orientación.

Por último, si algo o alguien se dirige hacia el usuario, éste lo oirá porque un tono específico le avisa para que salga de su trayectoria.

Futura comercialización

Tras tres años de trabajo conjunto, los investigadores han creado ya dos prototipos. Las pruebas realizadas hasta ahora con personas ciegas en diversos entornos reales, incluidas calles concurridas, han resultado exitosas.

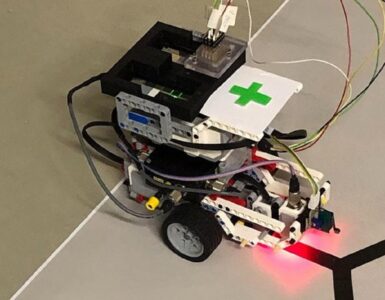

El primer diseño (M1) utiliza un sensor láser desarrollado por Siemens y originariamente ideado para detectar pasajeros en los coches, que puede calcular las distancias con objetos situados a entre cero y cinco metros de los usuarios, y en un campo visual de 60º.

El sistema, que está colocado dentro de unas gafas, ha permitido a los ciegos que realizaron las pruebas reconocer objetos, como sillas y árboles, a partir del sonido específico atribuido a cada imagen.

La segunda versión (M2) cuenta con dos cámaras digitales de video que se sitúan a ambos lados de un casco. Con ellas, se pueden detectar objetos en movimiento y predecir su curso.

Por otro lado, la Universidad de Marche ha colaborado estrechamente con el Insituto Cavazza para componer un sistema complementario de localización por GPS. Esta tecnología se emplearía para detectar la localización de la persona ciega que porte el dispositivo, y compaginar esta información con fuentes de datos adicionales, como servicios de mapeo. De esta forma, el usuario podría recibir indicaciones verbales que le indiquen hacia donde dirigirse para llegar al lugar que desee.

Según los investigadores, aún queda mucho trabajo por hacer hasta que la tecnología pueda salir al mercado. Especialmente hay que comprobar que es fiable al 100% para evitar riesgos como que una información errónea provoque que alguien cruce la calle cuando no debe.

A pesar de todo, los científicos confían en que algún día pueda comercializarse. Su éxito comercial dependerá de que el sistema sea miniaturizado y que las cámaras digitales que necesita puedan incorporarse a las propias gafas.

Hacer un comentario