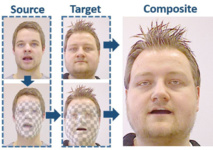

El sector de los gráficos por ordenador está cada vez más desarrollado, con avatares basados en personas reales, o incluso personajes animados de lo más realista creados completamente en un entorno sintético con las más avanzadas gráficas 3D de la industria. Sin embargo, lo que plantea un equipo de informáticos de Estados Unidos y Alemania es utilizar esa tecnología para transferir instantáneamente expresiones faciales de un rostro real a otro.

Matthias Niessner, profesor de la Universidad de Stanford especializado en superficies tridimensionales de gráficos por ordenador, se refiere al proceso como «reconstrucción facial en vivo», en un artículo publicado en The New York Times. Junto a otros compañeros de la universidad californiana y de las alemanas Max Planck Institute for Informatics y Erlangen-Nuremberg, donde estudió, han desarrollado un software que registra cada píxel de ambas caras y después transfiere la expresión.

De esta forma, la sonrisa de una persona aparece sin problema en un vídeo en directo de la cara de otra persona, aunque esta segunda no sonría. Bastará con un ordenador, dos cámaras especiales de captura de movimiento del cuerpo en 3D y el software que han creado, para tomar el control de una cara. Los resultados de la investigación se han publicado en un documento bajo el título “Transferencia de expresión en tiempo real para la reconstrucción facial” y ese el precisamente el objetivo, aunque el resultado impresiona más que la descripción.

La tecnología allana el camino a nuevas aplicaciones en el contexto de la realidad virtual y la teleconferencia. Así, se podría aplicar para mejorar el doblaje de películas -ajustando los movimientos faciales y la boca de los actores al idioma en cuestión-, hacer más realistas los vídeos de realidad virtual, crear avatares fotorrealistas para infinidad de usos o proporcionar una traducción instantánea.

Procedimiento

En los últimos años se han realizado varios estudios enfocados a la transferencia de expresiones faciales capturadas de un sujeto real para animar un personaje virtual. Sin embargo, la reconstrucción facial va un paso más allá, al trasladar las expresiones de origen a otro actor verdadero. Se trata de una tarea mucho más difícil, pues el más mínimo error en las expresiones transferidas o en la apariencia del vídeo sería percibido por el ojo humano.

Para lograr este objetivo, el software tiene que resolver desafiantes problemas algorítmicos bajo las restricciones del tiempo real. El primer paso es capturar con precisión las actuaciones faciales de los sujetos de origen y destino, usando para ello una cámara RGB-D, capaz de capturar imágenes en RGB y asociar a cada uno de los puntos tomados información de profundidad para crear el efecto tridimensional. En concreto, para esta investigación se ha utilizado la Asus Xtion Pro, aunque existen otros modelos conocidos como la Kinect de Microsoft.

Cada fotograma incluye información sobre los colores y la iluminación para reconstruir la escena. Para transferir la expresión, se calcula la diferencia entre las expresiones de origen y destino en el espacio de parámetros, y se modifican los parámetros de destino para que coincidan con las expresiones de origen. El proceso es bastante similar al utilizado por la tecnología de captura de movimiento.

El ordenador procesa la transferencia en unos 30 milisegundos, aunque algunas cámaras pueden requerir un poco más, pero seguirá siendo muy poco tiempo para que un observador humano lo perciba. Los investigadores han puesto a prueba su tecnología haciendo un seguimiento en vivo de varios actores en diferentes contextos, y el resultado es cuanto menos inquietante.

Sin embargo, también tiene algunas limitaciones. Por ejemplo, cuando se realizan movimientos de cabeza muy rápidos, puede dar lugar a fallos de seguimiento. También los entornos oscuros introducen ruido a los sensores RGB, lo que reduce la estabilidad de seguimiento temporal. Otra incidencia se produce a veces al copiar arrugas o diferencias significativas en la piel, lo que puede llevar a resultados inverosímiles. En este caso, el sistema funciona mucho mejor si la edad de los actores es similar.

Aplicaciones

La teleconferencia y la traducción instantánea son los dos campos donde esta tecnología tiene más que aportar. Precisamente Skype ha presentado ya un avance de su sistema de traducción de voz en tiempo real durante las videollamadas. Niessner asegura que, con un poco más de esfuerzo, se podría combinar esa traducción en tiempo real con la transferencia de expresiones faciales acordes. Así, si una persona de habla Inglesa estuviera hablando con un hablante de mandarín, cada uno parecería estar hablando el idioma del otro.

Los informáticos también creen que su método abre nuevas posibilidades para futuras líneas de investigación. Por ejemplo, en lugar de realizar el seguimiento del actor de origen con una cámara RGB-D, el vídeo de destino podría manipularse en base a la entrada de audio.

A pesar de todo, son conscientes de que la herramienta puede generar cierta preocupación en torno a los peligros de la alteración de la realidad visual. “Cuando aparecieron por primera vez programas como Photoshop, también había incertidumbre, pero ahora toda la industria de la publicidad gira en torno a ellos», subraya Niessner. El público ha sabido adaptarse y, además, existen técnicas para detectar cualquier alteración oculta de una imagen, algo que podría extrapolarse a la transformación en vídeo.

Hacer un comentario