Nuestros cerebros tienen una notable habilidad para distinguir voces individuales en un ambiente ruidoso, como una cafetería abarrotada o una concurrida calle de ciudad. Esto es algo que incluso los audífonos más avanzados luchan por conseguir.

Ahora, ingenieros de la Universidad de Columbia han desarrollado una tecnología experimental que imita la aptitud natural del cerebro para detectar y amplificar una voz entre muchas.

Alimentado por la inteligencia artificial, se trata de un audífono controlado por el cerebro que actúa como un filtro automático, discrimina las ondas cerebrales del usuario y aumenta la voz de la persona que quiere escuchar.

Aunque aún se encuentra en las primeras etapas de desarrollo, esta tecnología constituye un paso importante hacia mejores audífonos que permitan a los usuarios conversar con las personas que los rodean de manera transparente y eficiente. Los resultados se publican en Science Advances .

“El área del cerebro que procesa el sonido es extraordinariamente sensible y poderosa; puede amplificar una voz sobre otras, aparentemente sin esfuerzo», explica Nima Mesgarani, investigador del Mortimer B. Zuckerman Mind Brain Behavior Institute de Columbia, y autor principal del artículo, en un comunicado.

«Al crear un dispositivo que aprovecha el poder del cerebro, esperamos que nuestro trabajo conduzca a mejoras tecnológicas que permitan a los cientos de millones de personas con discapacidad auditiva en todo el mundo comunicarse tan fácilmente como lo hacen sus amigos y familiares».

Algoritmo de separación de voz

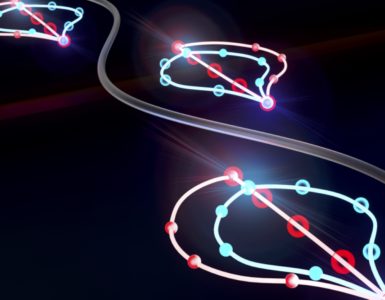

La tecnología básica de este trabajo es un algoritmo de separación de voz que puede reconocer y decodificar una voz, cualquier voz, desde el principio.

Los audífonos modernos son excelentes para amplificar el habla y suprimir ciertos tipos de ruido de fondo, como el tráfico. Sin embargo, tienen problemas para aumentar el volumen de una voz individual sobre otras.

El audífono controlado por el cerebro del equipo de Columbia es diferente. En lugar de depender únicamente de amplificadores de sonido externos, como los micrófonos, también controla las ondas cerebrales del oyente.

«Anteriormente, habíamos descubierto que cuando dos personas hablan entre sí, las ondas cerebrales del hablante comienzan a parecerse a las ondas cerebrales del oyente», añade Mesgarani.

Usando este conocimiento, el equipo combinó potentes algoritmos de separación del habla con redes neuronales, modelos matemáticos complejos que imitan las capacidades computacionales del cerebro.

Así crearon un sistema que primero separa las voces de los oradores individuales de un grupo, y luego compara las voces de cada orador con las ondas cerebrales de la persona que escucha. La voz cuyo patrón de voz coincide más estrechamente con las ondas cerebrales del oyente se amplifica sobre el resto.

Probado con éxito

El prototipo ha sido probado con éxito con pacientes de epilepsia, cuyas ondas cerebrales fueron observadas en tiempo real mediante electrodos implantados en el cerebro, mientras escuchaban a diferentes personas a la vez.

El algoritmo rastreó la atención de los pacientes mientras escuchaban a diferentes personas con las que no habían hablado con anterioridad. Cuando un paciente se concentró en un orador, el sistema amplificó automáticamente esa voz. Y cuando su atención cambió a otro conversador diferente, los niveles de volumen cambiaron para reflejar ese cambio.

Los investigadores ahora están investigando ahora cómo transformar este prototipo en un dispositivo no invasivo que se pueda colocar externamente en el cuero cabelludo o alrededor de la oreja. También esperan mejorar y refinar aún más el algoritmo para que pueda funcionar en una gama más amplia de entornos.

«Hasta ahora, solo lo hemos probado en un ambiente interior», señala Mesgarani. «Pero queremos asegurarnos de que pueda funcionar igual de bien en una calle concurrida de la ciudad o en un restaurante ruidoso, para que donde sea que vayan los usuarios, puedan experimentar plenamente el mundo y las personas que los rodean», concluye.

Referencia

Speaker-independent auditory attention decoding without access to clean speech sources. Cong Han et al. Science Advances, 15 May 2019: Vol. 5, no. 5, eaav6134. DOI:10.1126/sciadv.aav6134

Hacer un comentario