Percibir primero, actuar después. Sobre esta estrategia de control descansa la arquitectura de la mayoría de los robots actuales.

El proyecto eSMCs se ha propuesto como objetivo cambiar el paradigma, y generar modelos computacionales más dinámicos, donde la acción no es una mera consecuencia de la percepción, sino una parte integral del proceso de percepción.

Se trata de mejorar el comportamiento de los robots mediante modelos de percepción más cercanos a los humanos. Filósofos de la Universidad del País Vasco (UPV/EHU) trabajan en la mejora de los sistemas de percepción de los robots aplicando modelos humanos.

“El concepto de cómo la ciencia ha entendido la mente, a la hora de construir un robot o mirar el cerebro, es que sacas una foto, luego esa foto se procesa como si la mente fuera un ordenador, y realiza un reconocimiento de patrones. Hay diferentes tipos de algoritmos y de técnicas para identificar un objeto, escenas, etc… Sin embargo, la percepción orgánica, la del ser humano, es mucho más activa. El ojo, por ejemplo, realiza un montón de movimientos sacádicos —movimientos oculares pequeños y rápidos— que nosotros no vemos. Ver es estabilizar y reconocer objetos a través de esa acción visual, saber cómo cambia mi relación y sensación corporal respecto al movimiento”, explica Xabier Barandiaran, doctor en filosofía e investigador del IAS-Research (UPV/EHU) que bajo la dirección del investigador Ikerbasque Ezequiel di Paolo forma parte del proyecto Europeo eSMCs (Extending Sensorimotor Contingencies to Cognition / Extendiendo las Contingencias Sensomotoras a la Cognición).

Hasta ahora se ha creído que las sensaciones se procesaban y creaban la percepción que luego derivaba en razonamiento y acción. Para Barandiaran, la acción es parte integral de la percepción: “Nuestra idea fundamental es que cuando percibimos, lo que hay es una exploración activa, una coordinación particular con el entorno, como una especie de danza invisible que hace posible la visión”.

Pensar con el cuerpo y el entorno

Desde el proyecto eSMCs se quiere aplicar esa idea a los modelos computacionales utilizados en robots, mejorar su comportamiento y comprender así la naturaleza de la mente animal y humana.

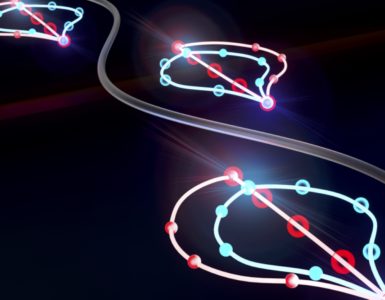

Para ello, los investigadores trabajan con las contingencias sensomotoras: relaciones regulares existentes entre acciones y cambios en las variaciones sensoriales asociados a dichas acciones. Un ejemplo de este tipo de contingencia es cuando uno bebe agua a la vez que habla, casi sin darse cuenta de haberlo hecho.

La interacción con el entorno se ha dado, “sin necesidad de representar internamente que esto es un vaso, y luego computar necesidades y planificar una acción”, explica Barandiaran, “la visión del vaso llama a la acción, se coordina con la sed, al tiempo que la propia presencia del agua en la mesa me basta para coordinar el ciclo visuomotor que termina con el vaso en mis labios”.

Lo mismo ocurre en los robots del proyecto eSMCs, “están todo el rato en movimiento, no se paran a pensar, piensan en acto, con el cuerpo y el entorno”, añade.

Los investigadores del proyecto eSMCs sostienen que las acciones juegan un papel clave no solo en la percepción, sino también en el desarrollo de capacidades congnitivas más complejas.

Por lo que creen que las contingencias sensomotoras pueden ser utilizadas para definir hábitos, intenciones, tendencias y estructuras mentales, dotando así al robot de un comportamiento más complejo y fluido.

Adaptarse y sentir

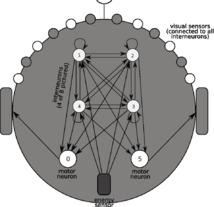

Así, en uno de los experimentos llevan a cabo una simulación robótica (desarrollada por Thomas Buhrmann, también integrante de este equipo de la UPV/EHU) en la que un agente tiene que discriminar entre lo que podríamos llamar un grano de acné y una picadura o bulto en la piel.

“El acné tiene punta, y la picadura no. Nuestro agente, igual que las personas, se queda en la punta y reconoce el acné, y cuando pasa por el bulto, lo ignora. Lo que buscamos modelar y explicar es ese momento perceptivo que se construye con la exploración activa de la piel, cuando sientes que ‘ah! he dado con el grano de acné’ y sigues deslizando tu dedo por encima», comenta Barandiaran. El modelo intenta identificar qué tipo de relación se establece entre los ciclos de movimiento y sensación y los patrones neurodinámicos que simulan en el “mini-cerebro” del robot.

En otro robot, construido en el Laboratorio de Inteligencia Artificial de la Universidad de Zurich, Puppy, un perro robótico, es capaz de adaptarse y “sentir” la textura del terreno en el que se mueve (resbaladizo, viscoso, rugoso, etc.) explorando las contingencias sensomotoras que se producen al andar.

El trabajo del equipo de investigación de la UPV/EHU se centra en la parte teórica de los modelos a desarrollar. “Como filósofos lo que hacemos, en gran medida, es definir conceptos. Nuestro mayor objetivo es poder definir conceptos técnicos como el de hábitat sensomotor, o el de patrón de coordinación sensomotora, así como el de hábito o el de la vida mental en su conjunto”.

Definir y dar forma matemática a los conceptos es fundamental para que el científico pueda aplicarlo en experimentos concretos, no solo con robots, sino también con humanos.

Los socios del centro Médico Universitario Hamburgo-Eppendorf, por ejemplo, estudian cómo cambia la percepción del tiempo y del espacio en pacientes con Parkinson, en dialogo con los desarrollos teóricos del equipo de la UPV/EHU.

Hacer un comentario