Un equipo de científicos de la Universidad de Maastricht, en los Países Bajos, ha conseguido desarrollar un método para saber quién habla a una persona y qué le está diciendo, únicamente analizando el cerebro del que escucha, sin contar con ninguna información extra.

Según publica la Universidad de Maastricht en un comunicado, este logro ha sido posible gracias al uso de neuroimágenes y de un algoritmo de “data mining” o minería de datos.

La neuroimagen incluye diversas técnicas (como la tomografía axial computarizada, la simulación de resonancia magnética o la exploración de resonancia magnética funcional, entre otras) que permiten captar tanto imágenes estructurales como funcionales del cerebro.

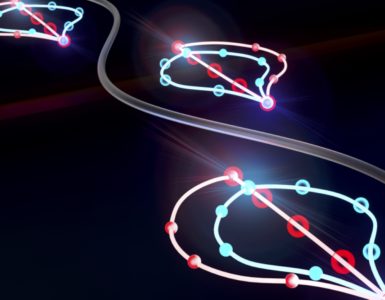

Mapa de la actividad cerebral

El data mining, por su parte, consiste en la extracción de información significativa que permanece implícita en un conjunto de datos. La minería da datos prepara, sondea y explora los datos para sacar la información oculta en ellos, es decir, en las relaciones entre dichos datos, en sus fluctuaciones y en sus dependencias.

Con estas técnicas, los investigadores consiguieron hacer un “mapa” de la actividad cerebral asociada con el reconocimiento de los sonidos y de las voces.

Según publican los científicos en un artículo aparecido en la revista Science, la combinación de imágenes obtenidas con resonancia magnética funcional de los cerebros de los participantes con la información desprendida del algoritmo de data mining permitió conocer quién le decía qué a una persona, a partir de las “huellas neuronales” que las señales de voz y del discurso producían como respuesta en la corteza auditiva del escuchante.

Estas huellas corticales estaban distribuidas espacialmente de una manera concreta, y se repetían cada vez que el participante escuchaba un discurso o una voz previamente aprendidos. Por eso, fue posible el reconocimiento, sólo a través de imágenes cerebrales, de lo que estaba escuchando el oyente y de a quién se lo estaba oyendo decir.

Huellas neuronales

Según explican los investigadores, los sonidos pronunciados y las voces pueden ser identificados porque cada uno produce una única “huella neuronal” en el cerebro de quien los escucha.

Siete personas fueron sometidas a la siguiente prueba: tuvieron que escuchar tres sonidos distintos (en concreto tres vocales), que fueron pronunciados por tres personas diferentes.

Entretanto, la actividad cerebral de los participantes fue registrada mediante una exploración de resonancia magnética funcional (fMRI). La tecnología fMRI mide la respuesta hemodinámica relacionada con la actividad neuronal del cerebro, y es una de las más novedosas técnicas de captación de neuroimágenes.

Con la ayuda del algoritmo de data mining o de minería de datos, los investigadores tradujeron esta actividad cerebral a pratrones únicos que determinaban la identidad de la persona que había pronunciado la vocal, y también la vocal pronunciada.

Se definieron de esta manera los patrones neuronales de la actividad cerebral que se correspondían con las diversas características acústicas de las vibraciones de las cuerdas vocales.

Procesamiento no jerárquico del sonido

Según los investigadores, estos patrones neuronales funcionan como auténticas huellas únicas y específicas: la huella neuronal de un sonido pronunciado no cambia si este sonido es producido por otra persona, mientras que la huella que deja un hablante concreto se mantiene siempre igual, incluso si dicho hablante dice algo distinto.

Este estudio ha revelado, por otro lado, que parte del complejo proceso de decodificación de sonidos tiene lugar en áreas del cerebro que anteriormente habían sido asociadas sólo con los estadios iniciales del procesamiento del sonido.

Los modelos neurocognitivos existentes asumen que los sonidos procesados implican activamente diversas regiones del cerebro, siguiendo una cierta jerarquía: tras un procesamiento simple en la corteza auditiva, un análisis más complejos (por ejemplo del sonido de las palabras) se desarrolla en regiones más especializadas del cerebro.

Sin embargo, los resultados de la presente investigación implican que el procesamiento del sonido es menos jerárquico y se expande más de lo que se pensaba por el misterioso cerebro.

Una de las posibles aplicaciones de estos nuevos conocimientos podría ser la de mejorar sistemas computacionales de reconocimiento de hablantes y de discurso.

Hacer un comentario