Un total de 26 expertos especialistas en IA, ciberseguridad y robótica de las universidades de Cambridge, Oxford, Yale, Stanford, así como de organismos no gubernamentales (OpenAI, Center for a New American Security, Electronic Frontier Foundation), alertan de los peligros potenciales de la Inteligencia Artificial por un posible uso malintencionado de esta tecnología por parte de Estados corruptos o de grupos criminales o terroristas.

En un informe advierten que en la próxima década la eficacia creciente de la inteligencia artificial (IA) podría potenciar la cibercriminalidad y conducir al uso de drones o robots con fines terroristas.

“Creemos que los ataques que serían posibles por el uso creciente de la IA serán particularmente efectivos, finamente dirigidos y difíciles de atribuir”, advierten en un comunicado.

El informe describe escenarios plausibles como consecuencia del desarrollo de la IA: alterar los sistemas informáticos de drones o vehículos autónomos para causar accidentes o provocar explosiones, es uno de ellos.

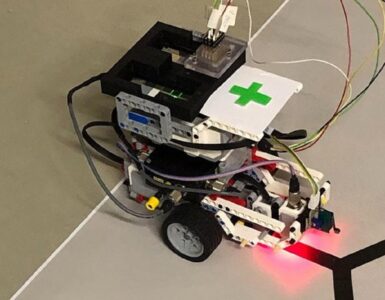

Otro escenario que consideran plausible es la manipulación de robots. Imaginan que es posible colar un robot entre otros que tengan funciones de limpieza en el interior de un ministerio o institución y dirigirlo a cometer un atentado contra una personalidad política: bastaría con que lo reconociera visualmente, se aproximara a él y procediera a explosionarse junto al objetivo.

Asimismo, consideran que los ataques dirigidos a una institución o empresa para robar o destruir información específica, algo que ya ocurre en la actualidad, podrían perfeccionarse y desarrollarse con mayor frecuencia y eficacia merced a la IA.

Efectos políticos

La IA podría asimismo facilitar la manipulación de elecciones políticas en diferentes países a través de las redes sociales usando cuentas automatizadas (bots), algo que ya se ha hecho, aunque no a la escala que podría alcanzar esta manipulación de la mano de la Inteligencia Artificial tal como va a desarrollarse en los próximos años.

Esta amenaza puede plantear serios problemas a la estabilidad política de algunos países y tal vez desencadenar graves conflictos, ya sean nacionales o internacionales, según este informe.

Otra posibilidad es realizar videos falsos con un realismo extremo que confundirían fácilmente a la población o el electorado, con la finalidad de desacreditar o impulsar a determinados responsables políticos.

Un último escenario descrito por estos expertos se refiere a la posibilidad de que dirigentes de algunos países hagan uso de la IA para vigilar clandestinamente a sus ciudadanos. Y especifican: estas preocupaciones son más significativas en el contexto de Estados autoritarios, pero también pueden socavar la capacidad de las democracias para sostener debates públicos auténticos.

Recomendaciones

El informe concluye con una serie de recomendaciones orientadas a prevenir estos posibles escenarios.

Las recomendaciones pasan por reforzar las capacidades de la ciberseguridad, incorporar nuevas normas para prevenir posibles abusos de la IA, promover la cultura de la responsabilidad potenciando la educación y la ética, alcanzar nuevos desarrollos tecnológicos que eviten esta posible deriva de la IA y acometer nuevas políticas para sensibilizar a la población y organizar a la sociedad ante esta amenaza potencial.

La IA es una rama de las ciencias computacionales encargada de estudiar modelos de cómputo capaces de realizar actividades propias de los seres humanos como el razonamiento y la conducta.

Los sistemas de IA son cotidianos actualmente en campos como la economía, la medicina, la ingeniería y el ejército, y se han usado en gran variedad de aplicaciones de software, juegos de estrategia, como ajedrez de ordenador, y otros videojuegos.

Y aunque no es la primera vez que diferentes expertos advierten de los riesgos potenciales de la IA, este informe aporta una panorámica general sobre cómo esta rama de la ingeniería informática crea nuevas amenazas para las personas y la sociedad en campos como la ciberseguridad, las personas físicas y las autoridades políticas.

Referencia

The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation. Future of Humanity Institute; University of Oxford; Centre for the Study of Existential Risk; University of Cambridge; Center for a New American Security; Electronic Frontier Foundation; OpenAI. Feb. 2018.

Hacer un comentario