Investigadores del Laboratorio Nacional de Los Álamos en Estados Unidos han descubierto que las redes neuronales artificiales necesitan períodos de descanso similares a los que el sueño proporciona a los cerebros biológicos.

Lo han comprobado construyendo cerebros artificiales mediante poderosas redes neuronales artificiales: tienen una necesidad equivalente a la que experimentan las neuronas naturales cuando están estresadas.

Lo primero que observaron fue que las simulaciones informáticas de la red neuronal con la que trabajaban después de sucesivos periodos de aprendizaje sin supervisión se volvían inestables.

Solo cuando expusieron las redes neuronales artificiales a estados análogos a las olas que experimentan los cerebros vivos durante el sueño, se restableció la estabilidad.

Así pudieron determinar que los procesadores neuromórficos, integrados por circuitos analógicos que imitan las estructuras neuronales ubicadas en el sistema nervioso, deben aprender como lo hacen los sistemas biológicos durante el desarrollo infantil.

Proceso Eureka

El descubrimiento se produjo cuando el equipo de investigación desarrollaba redes neuronales que imitan cómo los humanos y otros sistemas biológicos aprenden a ver.

Inicialmente, el grupo tuvo problemas para estabilizar las redes neuronales simuladas que se sometían a un entrenamiento para conformar un diccionario sin supervisión, lo que implica clasificar objetos sin tener ejemplos previos para compararlos.

«La cuestión de cómo evitar que los sistemas de aprendizaje se vuelvan inestables en realidad solo surge cuando se intenta utilizar procesadores neuromórficos biológicamente realistas o cuando se trata de entender la biología en sí misma», explica el coautor del estudio, Garrett Kenyon, en un comunicado.

«La gran mayoría de los investigadores de aprendizaje automático, aprendizaje profundo e inteligencia artificial, nunca encuentran este problema porque los sistemas artificiales que estudian realizan operaciones matemáticas globales que regulan la dinámica general del sistema».

Último recurso

La decisión de poner sus redes neuronales en un estado de sueño se consideró un último recurso, dijo el equipo.

Experimentaron con varios tipos de ruido, más o menos comparables con la estática que podría encontrarse entre diferentes emisoras mientras sintonizamos una radio.

Los mejores resultados se obtuvieron al utilizar ondas de ruido gaussiano, que incluyen una amplia gama de frecuencias y amplitudes.

Se cree que este ruido imita la entrada recibida por las neuronas biológicas durante el sueño de ondas lentas, que permite al cerebro recuperarse de sus actividades diarias y consolidar recuerdos.

Los resultados sugieren que el sueño de ondas lentas puede actuar, en parte, para garantizar que las neuronas corticales mantengan su estabilidad y no alucinen.

Eso significa que las neuronas artificiales necesitan algo parecido a lo que precisan las neuronas vivas para mantenerse estables después de un periodo de intensa actividad.

Primera aplicación

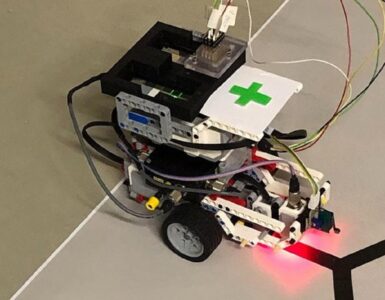

El equipo ahora está buscando implementar su algoritmo en el chip neuromórfico Loihi de Intel.

Loihi es un chip neuromórfico que puede detectar olores con una pequeña muestra de entrenamiento, alta precisión y un sistema que consume solo 300 vatios.

Procesa el equivalente a más de un millón de neuronas y es hasta 1.000 veces más rápido y 10.000 veces más eficiente que los procesadores convencionales, según Intel.

Al permitir que Loihi duerma de vez en cuando, podrá procesar de manera estable, por ejemplo, los datos de una cámara de silicio que toma imágenes de la retina en tiempo real, sin necesidad de dilatar previamente la pupila.

En caso de que esta tecnología prospere, lo más probable es que los androides y otras máquinas inteligentes del futuro, incluyan en sus programas el correspondiente sueño para estabilizar sus redes neuronales.

Los resultados de esta investigación se presentan el 14 de junio en la conferencia virtual Women in Computer Vision.

Referencia

Using Sinusoidally-Modulated Noise as a Surrogate for Slow-Wave Sleep to Accomplish Stable Unsupervised Dictionary Learning in a Spike-Based Sparse Coding Model. Y. Watkins, Edward Kim, A. Sornborger, G.T. Kenyon. IEEE International Conference on Computer Vision and Pattern Recognition Workshop, CVPR-W 2020.

Hacer un comentario