Una nueva técnica de imágenes acústicas utiliza un conjunto desordenado de esferas de plástico para amplificar ondas de sonido cortas: combinadas con Inteligencia Artificial, reducen la complejidad y la potencia computacional necesaria para obtener imágenes de alta resolución de objetos que están más allá del límite de la difracción de la luz.

Lo ha conseguido un equipo de investigadores de la Escuela Politécnica Federal (EPFL) de Zúrich liderado por Romain Fleury: acopló metamateriales y redes neuronales y demostró que el sonido se puede utilizar para obtener imágenes precisas del mundo invisible. Los resultados se publican en la revista Physical Review X.

La formación de imágenes permite representar un objeto analizando de forma remota las ondas, ya sean de luz o sonido, que emite el objeto que se quiere representar. Esta técnica tiene una limitación: la precisión de la imagen así obtenida depende de la longitud de la onda.

Precisión sorprendente

Esta limitación impuesta por la longitud de onda se puede superar mediante algunos recursos técnicos, que suponen un costo considerable en términos económicos y computacionales.

Los investigadores suizos han conseguido una técnica más simple: captura detalles muy pequeños de la longitud de onda y alcanza una precisión inédita de la imagen de lo “invisible”.

La precisión alcanzada por este sistema es sorprendente: una onda larga de sonido, y por tanto no muy clara, puede dibujar detalles hasta 30 veces más pequeños que su longitud de onda.

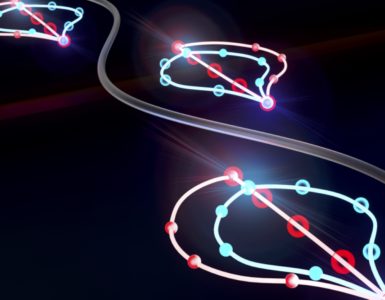

El material que permite esta proeza tecnológica es un material artificial creado desde cero con la ayuda de la Inteligencia Artificial (IA). Este metamaterial, cuando adopta la forma deseada, es capaz de enfocar con precisión las ondas que emite.

La segunda parte de esta proeza es haber introducido en el proceso un sistema de redes neuronales artificiales capaces de decodificar de forma rápida y eficiente la información escondida en la onda que emite el metamaterial.

Viendo lo invisible

En esta investigación, el equipo de Romain Fleury fue más allá del límite de difracción de la luz: impide que se puedan distinguir dos estructuras independientes que están separadas menos de 200 nanómetros (un nanómetro equivale a la milmillonésima parte del metro).

Más allá de ese límite está el reino físico de lo invisible, de los eventos que rigen la vida de las células y nuestra propia vida, y que no podemos ver porque están a escala infinitesimal.

Los investigadores han usado un truco inteligente para bordear esta limitación de la microscopía óptica: colocaron un panel compuesto por 64 mini altavoces que se activan según los píxeles de una imagen.

Este panel forma una fuente de sonido con detalles espaciales muy finos, que reproducen imágenes de dígitos del 0 al 9, extraídas de una base de datos de unas 70.000 versiones manuscritas de los dígitos.

Frente al panel hay una bolsa que contiene 39 resonadores de Helmholtz, absorbentes acústicos artificiales que eliminan o absorben un estrecho margen de frecuencias.

Los resonadores son esferas perforadas de 10 centímetros de diámetro que forman el metamaterial. El sonido emitido por la fuente es devuelto por esta estructura y recibido por cuatro micrófonos colocados a pocos metros de distancia.

Dos algoritmos diferentes de aprendizaje automático utilizaron los datos obtenidos por los micrófonos, aún sin procesar, para aprender, explica la revista Physics: uno reconstruyó el patrón con la mayor precisión posible y el otro lo clasificó como uno de los diez dígitos. Los algoritmos se entrenaron primero en un conjunto de señales conocidas y luego se probaron con nuevas señales que no se encontraron en el conjunto de entrenamiento.

Límite superado

La tasa de éxito ronda el 90%: “al reconstruir imágenes de figuras con una resolución de unos pocos centímetros, mientras la longitud de onda del sonido es del orden de un metro, hemos superado ampliamente el límite de difracción”, resume Romain Fleury en un comunicado.

Y añade: “además, la propensión a la absorción, que se consideraba un gran inconveniente de los metamateriales, resulta ser un activo cuando se utilizan redes neuronales: hemos descubierto que funcionan mejor cuando hay mucha absorción.»

Esta experiencia abre perspectivas interesantes, particularmente en los campos de la imagenología médica y la bioingeniería: para las imágenes médicas, poder usar ondas largas para ver cosas muy pequeñas es un gran avance, destacan los investigadores.

Las ondas largas permiten el uso de frecuencias mucho más bajas, lo que permite que las técnicas de imágenes acústicas funcionen incluso a través del tejido óseo opaco, o en el caso de imágenes que utilizan ondas electromagnéticas, son menos perjudiciales para la salud, dice el investigador. En este caso, las redes neuronales no aprenderían a reconocer o visualizar números, sino estructuras biológicas, concluye.

Referencia

Far-Field Subwavelength Acoustic Imaging by Deep Learning. Bakhtiyar Orazbayev and Romain Fleury. Phys. Rev. X 10, 031029, 7 August 2020.DOI: 10.1103 / PhysRevX.10.031029

Hacer un comentario