Hasta 43 músculos se pueden ejercitar en la cara. Muchos de ellos ofrecen información sobre el estado emocional, el nivel de interés o de alerta de la persona. En otras ocasiones sirven como medio de comunicación efectivo que traspasa la barrera de los idiomas. Y a veces los datos se pierden, se ignoran o malinterpretan.

Rana el Kaliouby se opone a que esa información se desperdicie. Ella es cofundadora de una startup tecnológica de rápido crecimiento, Affectiva, puesta en marcha en 2009 junto a Rosalind Picard, por aquel entonces compañera en el Media Lab del Instituto Tecnológico de Massachusetts (MIT), en Estados Unidos. En poco tiempo han conseguido estar a la vanguardia en tecnología que permita usar los ordenadores para detectar e interpretar expresiones faciales humanas.

Es lo que se conoce como computación afectiva, campo que busca cerrar la brecha de comunicación entre personas y máquinas incorporando un nuevo modo de interacción, el que brinda el lenguaje no verbal. Como explica el Kaliouby en un reportaje en la revista online Smithsonian, su premisa es que “las emociones son importantes. El smartphone sabe quién eres y de dónde, pero no sabe cómo te sientes. Nuestro objetivo es solucionar eso».

En esta línea, defiende la práctica integración de los ordenadores en las rutinas de la vida diaria a través de su software. Así, imagina la tecnología para controlar la iluminación, la temperatura o la música del hogar en función del estado de ánimo, o aplicaciones que adaptan el contenido de una película en base a las reacciones subconscientes mientras se visualiza. Otra opción serían programas que controlan la expresión durante la conducción, alertando ante la falta de atención, somnolencia o enfado.

La tecnología de Affectiva también se podría aplicar al cuidado de la salud. Para ello prevén un programa que se ejecutaría en segundo plano en el teléfono u ordenador del usuario para compilar un registro de su estado de ánimo en cada momento a lo largo de un período de tiempo -desde un día a un mes- y correlacionarlo con el tiempo o cualquier otra cosa que el dispositivo pueda medir. «Se podría tener en el teléfono y avisarte de que cada vez que ‘X’ llama tienes una expresión negativa, algo de lo que no te habías percatado», cita como ejemplo.

La siguiente revolución tecnológica

En definitiva, la investigadora promueve la computación afectiva como el siguiente paso lógico en la evolución del teclado al ratón, y de la pantalla táctil al reconocimiento de voz. Affectiva lanzó su primer kit de desarrollo de software comercial la pasada primavera, con idea de que aquellos desarrolladores interesados en los estados emocionales en tiempo real de los usuarios se pudieran incorporar a la investigación, creando sus propios programas de música, juegos u otras aplicaciones.

El siguiente paso este otoño fue el lanzamiento de ‘Emotion As a Service’, un programa basado en la nube que permite subir vídeos para analizarlos. La herramienta sería de utilidad para un candidato a punto de ser entrevistado para un trabajo, para saber si parece ansioso o incluso si sonríe demasiado. O para una aerolínea que busca auxiliares de vuelo, para filtrar aquellos que ofrezcan la sonrisa más convincente.

Hasta ahora, los principales clientes de la startup han sido del sector del marketing, la publicidad y los medios de comunicación, como recogió Tendencias 21. El software automatiza el proceso de gestionar focus groups, herramienta propia de estos campos que consiste en reunir grupos de personas con características determinadas en función de demografía, intereses o de otro tipo, para conocer sus opiniones, actitudes o reacciones frente a un concepto, producto o servicio. De esta forma el sistema graba directamente las reacciones, sin necesidad de responder a cuestionarios. Además, al estar conectado a Internet, el software amplía el potencial del estudio a todo el mundo, o al menos a aquellos que dispongan de una cámara web conectada al ordenador o un dispositivo móvil.

El feedback de Affectiva es implacable. El software se utilizó por ejemplo para crear una especie de “recoge muestras de sonrisas”, una máquina que dispensa golosinas a aquellos clientes que sonríen a la cámara. Con un poco más de esfuerzo y estudio, la herramienta se podría extrapolar a la vigilancia en zonas concurridas, para identificar a posibles ladrones o como detector de mentiras. Sin embargo, el objetivo principal de Kaliouby es utilizar esta tecnología para “mejorar la vida de las personas y ayudarles a comunicarse mejor, no sólo para que los anunciantes puedan vender más productos», matiza.

La mayor base de datos de emociones

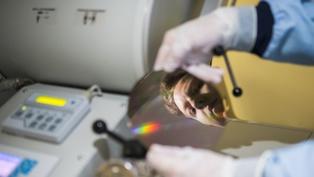

El funcionamiento del sistema es sencillo y no requiere más que un monitor y una cámara web, o dispositivo móvil. El software localiza el rostro del usuario y dibuja una caja a su alrededor en la pantalla. Identifica un conjunto de puntos para realizar el seguimiento: los extremos de los ojos y la boca, la punta de la nariz, y así sucesivamente. Veinte veces por segundo, el software busca «unidades de acción», esos movimientos a veces fugaces de los músculos de la cara.

El programa estándar de Affectiva muestra unos 15 de estos en cualquier momento, y los analiza como manifestaciones de siete emociones básicas: alegría, tristeza, sorpresa, miedo, enfado, asco y desprecio, además del interés y la confusión. Así, con una sonrisa la medida de felicidad se dispara, mientras que al doblar el labio con una mueca el programa detecta desprecio o disgusto.

Poco a poco ha creado un archivo con más de tres millones de vídeos de caras, subidos por usuarios de unos 75 países de todo el mundo reclutados a través de Internet. Cientos de miles de ellos se han analizado siguiendo el sistema de Codificación Facial (FACS), un estándar común que se utiliza para clasificar sistemáticamente la expresión física de emociones. El sistema computarizado detecta automáticamente los rostros en vídeos, extrae las características geométricas de las caras, y después crea perfiles temporales de cada movimiento facial.

Como resultado, la base de datos cuenta ahora con cerca de 40 mil millones de «puntos de referencia de emociones», un recurso que sitúa a la startup con sede en Massachusetts lejos de otras empresas del mismo ámbito como Emotient, probablemente, su competidor más cercano.

Con todo, la premisa de la computación afectiva se basa en lo que equivale a un acto de fe, que una sonrisa transmite una sensación de felicidad, placer o diversión. Por supuesto, al igual que se puede engañar a una persona con una sonrisa falsa o un enfado fingido, no se puede esperar más de un programa de ordenador, o al menos por ahora.

De eso se encarga Daniel McDuff, que se unió a la empresa como director de investigación. Sorprendentemente, encontró que las personas mayores son más expresivas, especialmente si se trata de emociones positivas, que los más jóvenes. McDuff fue aún más lejos, detectando la emoción de la Mona Lisa, cuya casi enigmática sonrisa ha intrigado a quien la observa durante 500 años. Pese a que el software funciona mejor con expresiones cambiantes, es decir, en imágenes no estáticas, no se encontró evidencia de una sonrisa auténtica de La Gioconda, sino más bien una combinación de acciones que sugiere más bien cierto nivel de incomodidad.

Hacer un comentario