A principios de 1900, Wilhelm von Osten, entrenador de caballos y matemático alemán, le dijo al mundo que su caballo sabía matemáticas. Durante años, Von Osten recorrió Alemania para demostrar que Clever Hans, como se llamaba el cuadrúpedo, era capaz de calcular ecuaciones simples, lo que manifestaba levantando la pata ante la respuesta correcta.

Sin embargo, un extenso estudio llevado a cabo por el psicólogo Carl Stumpf encontró que Clever Hans no resolvía problemas, más bien respondía a señales visuales. Al golpear el número correcto, el entrenador y la multitud estallaban en aplausos, por lo que el caballo se detenía. Cuando no podía ver esas expresiones, seguía intentándolo una y otra vez.

La informática puede aprender mucho de Clever Hans. Por ejemplo, que los sistemas de inteligencia artificial creados hasta ahora han aprendido lo suficiente para dar una respuesta correcta, pero sin una verdadera comprensión de la información. Y eso significa que podrían ser fáciles de engañar.

Para prepararse frente a posibles ataques, se está llevando a cabo una investigación en la que participan desde científicos de la Universidad Estatal de Pensilvania, a Google o el mismísimo Ejército norteamericano. En las teorías planteadas en el estudio, del que da cuenta un artículo publicado en PopularScience, un atacante podría cambiar lo que ve un vehículo sin conductor, activar el reconocimiento de voz de cualquier teléfono para entrar a una web con malware o dejar que un virus acceda al servidor de seguridad en una red.

Este tipo de ataques utiliza modelos conflictivos, es decir, imágenes, sonidos o texto que pueden resultar normales ante los ojos de un espectador humano, pero no así para las máquinas. Conocer este peligro desde el principio permite a los investigadores proveerse de las herramientas para solucionar las deficiencias, consiguiendo algoritmos incluso más eficientes.

Redes neuronales profundas

La corriente principal de Inteligencia Artificial hoy en día involucra redes neuronales profundas, que tratan de reproducir el funcionamiento del cerebro humano. La idea general es descentralizar el cálculo a través de miles de pequeñas ecuaciones (las neuronas) que toman datos, los procesan y transmiten a otra capa de miles de pequeñas ecuaciones.

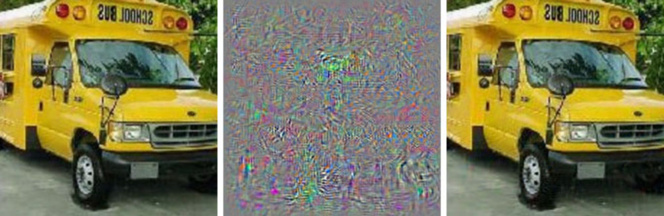

Estos algoritmos aprenden de la misma forma que los humanos, con modelos basados en la repetición, asociación o imitación. Sin embargo, los investigadores detectaron que podrían sufrir un ataque con la introducción de datos engañosos a propósito, lo que han denominado modelos conflictivos. «Mostramos una foto que es claramente la imagen de un autobús escolar, y hacemos pensar que es un avestruz», explica Ian Goodfellow, investigador de Google que ha impulsado gran parte del trabajo.

Con sólo alterar un cuatro por ciento de las imágenes introducidas en una red neuronal profunda, los investigadores consiguieron engañar en la clasificación con una tasa de éxito del 97 por ciento. Incluso cuando no sabían cómo la red procesaba las imágenes pudieron engañarla con casi el 85 por ciento de exactitud. Esta última es la primera investigación documentada de lo que se conoce como ataque de caja negra, sin conocer su arquitectura, y resulta de gran interés por ser el escenario más probable en el mundo real.

En su estudio, los investigadores llevaron a cabo un ataque real contra una red neuronal profunda que clasifica imágenes utilizando MetaMind, una herramienta online para desarrolladores. El equipo construyó y entrenó la red, pero su algoritmo de ataque operó de forma independiente a la arquitectura. De esta forma consiguieron forzar un ataque de caja negra que generó fallos en la clasificación con una precisión de hasta el 84,24 por ciento.

Por otra parte, dos grupos de la Universidad de Berkeley y Georgetown han desarrollado con éxito algoritmos que pueden emitir comandos de voz para los asistentes personales digitales, como Siri y Google Now, en forma de ráfagas de sonido irreconocibles para el oído humano. Mientras una persona sólo oiría un ruido blanco aleatorio, un asistente sería activado para realizar acciones ajenas a la intención de su propietario. De hecho, en los experimentos llevados a cabo, consiguieron activar reconocedores de audio de código abierto, a Siri y Google Now con una precisión superior al 90 por ciento.

El ruido suena como una transmisión de ciencia-ficción; una mezcla confusa de ruido blanco y voz humana, pero sin duda irreconocible como un comando. Con este ataque, cualquier teléfono que escucha el ruido podría verse obligado, sin saberlo, a visitar la página web que reproduce el ruido y, así, infectar a otros teléfonos cercanos, o descargar en silencio malware en el dispositivo.

Tanto este ataque como el de caja negra pueden ocurrir porque las máquinas están capacitadas para pensar que hay datos legibles o importantes en casi todas las entradas, y también que algunas son más comunes que otras.

En alerta

No es de extrañar que este área de investigación haya despertado el interés militar. De hecho, el Laboratorio de Investigación del Ejército de EEUU ha subvencionado al menos dos de los trabajos más recientes, incluyendo el ataque de caja negra. Su interés radica en la detección y detención de datos que puedan inducir a error, en una época en que no todas las fuentes de información pueden examinarse adecuadamente. Igualmente interesa de cara al desarrollo de robots, tanques y otros vehículos autónomos, para conseguir inmunidad frente a potenciales ataques adversarios.

Con todo, y mientras la investigación siga su curso, los expertos alertan de que cualquier sistema que utilice redes neuronales profundas debería ser cauteloso frente a la posibilidad de ataques. No hay que olvidar que tanto el aprendizaje automático como los sistemas de inteligencia artificial están todavía en su etapa inicial de crecimiento, por lo que cualquier descuido de seguridad puede tener resultados drásticos. «Al menos en seguridad informática, por desgracia, los atacantes van siempre por delante», admiten.

Hacer un comentario