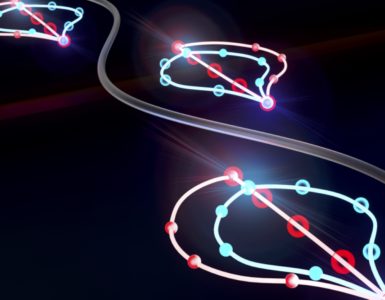

Un nuevo enfoque de Inteligencia Artificial (IA) basado en señales inalámbricas podría ayudar a revelar nuestras emociones internas. Mediante ondas de radio utilizadas para medir la frecuencia cardíaca y las señales respiratorias, el nuevo sistema desarrollado en la Universidad Queen Mary de Londres logra predecir cómo se siente una persona incluso en ausencia de otras señales visuales, como por ejemplo expresiones faciales.

De acuerdo a un comunicado, los investigadores sostienen que aunque ya se han realizado experiencias similares, el nuevo enfoque destaca de sus antecesores por la utilización de técnicas de aprendizaje profundo, que reemplazan a las tradicionales metodologías de aprendizaje automático.

Aunque ambas técnicas son ramas de la Inteligencia Artificial, tienen sus diferencias y se aplican en distintos contextos. Según los investigadores ingleses, el aprendizaje profundo les permite evaluar los datos de una manera similar al funcionamiento de un cerebro humano, analizando diferentes capas de información y haciendo conexiones entre ellas.

Por el contrario, el aprendizaje automático aplicado a esta clase de estudios mide las emociones de manera dependiente del sujeto, según los científicos. Se basan en registrar una señal de un individuo específico y usarla para predecir sus emociones en una etapa posterior.

Mientras el aprendizaje automático utiliza un algoritmo previamente determinado para identificar y clasificar estados emocionales dentro de los datos obtenidos, el aprendizaje profundo empleado en la nueva investigación aplica una red neuronal artificial que “aprende” sus propias características a partir de datos sin procesar.

En otras palabras, se va enriqueciendo y optimizando con información en tiempo real, aprendiendo de las propias experiencias y “moldeándose” en consecuencia, tal como lo hace el cerebro humano.

Emociones y señales

Este nuevo enfoque ha sido el responsable del éxito de los resultados obtenidos con la investigación, publicada en la revista Plos One.

En primer término, los participantes en el estudio apreciaron un video seleccionado por los investigadores por su capacidad para evocar alguno o varios de los cuatro tipos básicos de emociones: ira, tristeza, alegría y placer.

Al mismo tiempo que la persona apreciaba el video, los científicos emitieron señales de radio inofensivas, similares a las transmitidas por sistemas inalámbricos como el radar o las redes WiFi, hacia el participante.

Al analizar los cambios producidos en estas señales como causa de leves movimientos corporales, los especialistas obtuvieron información sobre la frecuencia cardíaca y respiratoria de cada voluntario.

A partir de la misma, y trabajando con los sistemas de aprendizaje profundo, fueron capaces de determinar las emociones que dominaban a cada individuo mientras observaban el video.

Información invisible

Según los científicos, estos métodos que analizan información “invisible” para detectar emociones, como puede ser por ejemplo la frecuencia cardíaca, tienen amplias ventajas sobre aquellos que trabajan con información visible, como análisis de expresiones faciales o gestos.

Entre las ventajas destacan una menor dependencia de interpretaciones subjetivas y la utilización de datos más fiables y precisos.

Según Achintha Avin Ihalage, una de las autoras del estudio, “con las técnicas de aprendizaje profundo aplicadas hemos demostrado que podemos medir con precisión las emociones de una manera independiente del sujeto, observando una colección completa de señales de diferentes individuos y aprendiendo de estos datos para predecir las emociones de las personas”, concluyó.

Ahora, los investigadores trabajan en nuevos estudios en los cuales buscarán identificar mediante métodos inalámbricos económicos como el WiFi las emociones de muchas personas reunidas en un espacio en concreto, como por ejemplo una oficina o local comercial.

Referencia

Deep learning framework for subject-independent emotion detection using wireless signals. Ahsan Noor Khan, Achintha Avin Ihalage, Yihan Ma, Baiyang Liu, Yujie Liu and Yang Hao. Plos One (2021).DOI:https://doi.org/10.1371/journal.pone.0242946

Foto: Daniele Levis Pelusi en Unsplash.

Video y podcast: editados por Pablo Javier Piacente en base a elementos y fuentes libres de derechos de autor.

Hacer un comentario