Si bien los vehículos aéreos no tripulados (UAV) o drones nacieron al servicio de misiones militares y vigilancia, encuentran cada vez más aplicaciones civiles, entre ellas, las relacionadas con la fotografía. Ya la Universidad de Illinois en Urbana-Champaig impulsó hace unos meses un sistema para tomar fotos desde uno de estos helicópteros automatizados con una cámara digital de gama baja, que destacaba sobre todo por su bajo peso. Superponiendo varias fotos de detalle de poca calidad, se conseguían panorámicas muy interesantes.

Ahora, un equipo de investigación del Instituto Tecnológico de Massachusetts (MIT) y la Universidad de Cornell, en Estados Unidos, aspiran a convertir estos drones en pequeños asistentes de iluminación. Y es que, aunque la luz es crucial en el arte de la fotografía, conseguir la configuración adecuada puede ser un proceso lento y engorroso, tarea que se complica aún más fuera del estudio, de ahí que buscaran un sistema para salvar este escollo.

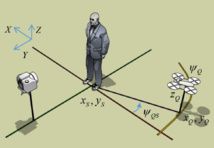

Según explica el MIT en un comunicado, equiparon los drones con una fuente de luz continua, un flash y un telemetro láser, capacitándolos para asumir automáticamente las posiciones necesarias para conseguir los efectos de iluminación especificados a través de una interfaz de la cámara, montada de forma sencilla e intuitiva.

De momento, el prototipo trabaja para conseguir el difícil efecto de luz de borde o contorno, con el que se busca destacar el relieve y perfilar los contraluces. Según Manohar Srikanth, estudiante del MIT autor del estudio junto al profesor de Ciencias de la Computación y la Ingeniería Frédo Durand, eligió este tipo de iluminación para sus experimentos iniciales precisamente por la dificultad que supone. "Es muy sensible a la posición de la luz", comenta Srikanth. "Si se mueve, por ejemplo, por un pie, la apariencia cambia drásticamente", añade.

Control intuitivo

Con el nuevo sistema, el fotógrafo indica la dirección de la que debe venir la luz, y el dron se posiciona en ese lado del objeto. A continuación debe especificar el ancho del borde como un porcentaje de su valor inicial, repitiendo el proceso hasta conseguir el efecto deseado.

A partir de entonces, el robot mantiene automáticamente la anchura especificada. "Si el sujeto se sitúa frente al fotógrafo, el borde que se ve es el del hombro, pero si se gira hacia un lado estará exponiendo su pecho a la luz, por lo que la luz de borde será más gruesa", explica el investigador. "Así pues, para compensar el movimiento del cuerpo, la luz tiene que cambiar su posición de manera drástica", añade.

De la misma manera, el sistema puede compensar los movimientos del fotógrafo. En ambos casos, la propia cámara suministra la señal de control. Esta produce una imagen unas 20 veces por segundo, pero no se almacenan en la propia tarjeta de memoria, sino que se transmiten a un equipo que ejecuta el algoritmo de control de los investigadores. El algoritmo evalúa la anchura del borde y ajusta la posición del robot en consecuencia.

"El reto era trabajar con la difícil dinámica de un dron y la retroalimentación de la iluminación estimada", afirma Durand. Ahí es donde han centrado sus esfuerzos, para asegurarse de que el control del dron pueda actuar a la gran velocidad que se necesita sólo para mantener el vuelo y hacer frente a la información del telémetro láser y la estimación borde-iluminación.

Todo ello requiere cierta racionalización algorítmica. "Cuando empezamos a desarrollarlo dimos con un algoritmo muy completo que analizaba toda la silueta del objeto y trataba de averiguar las propiedades morfológicas, la curva del borde, y así sucesivamente, empleando para ello demasiado tiempo ", recuerda Srikanth.

En su lugar, el algoritmo final simplemente busca las gradaciones más drásticas de intensidad luminosa en toda la imagen y mide su anchura. Con el sujeto iluminado, la mayoría de esas mediciones se concentrarán alrededor del mismo valor, que el algoritmo toma como anchura del borde. En los experimentos, esta aproximación rápida fue capaz de seguir el ritmo de los movimientos tanto del sujeto como del fotógrafo, manteniendo una anchura del borde consistente.

Desafío

Los investigadores probaron su prototipo en un estudio de captura de movimiento, que utiliza una serie de cámaras de alta velocidad para medir con precisión milimétrica la posición de etiquetas reflectantes de luz especialmente diseñadas; varias de las cuales se colocaron en el helicóptero.

Según Srikanth, el propósito de las pruebas era evaluar el algoritmo de control. Los algoritmos que miden ubicación de robots "basándose únicamente en las mediciones de los sensores a bordo son un área importante de la investigación en robótica, y el nuevo sistema podría trabajar con cualquiera de ellos. Incluso la luz de borde no requiere la precisión milimétrica del estudio de captura de movimiento". En ese sentido, el investigador calcula que sólo se necesita una resolución de 2 o 3 centímetros.

"La luz de borde es un efecto particularmente interesante, ya que se debe colocar con precisión la iluminación para resaltar las siluetas", explica Ravi Ramamoorthi, profesor de Ciencias de la Computación e Ingeniería en la Universidad de California en San Diego. "Otros efectos son en cierto sentido más fáciles, pues no se necesita un control y posicionamiento de la iluminación tan preciso, por lo que puede ser suficiente con el posicionamiento estático manual", añade el profesor.

Aunque los investigadores reconocen que, de momento, es un desafío tener el sistema UAV fuera del laboratorio y funcionando en el mundo real, no lo descartan como algo factible dentro de poco, dado el rápido avance de estas tecnologías.

Hacer un comentario