Ingenieros informáticos de la Universidad de California en Davis (UCD) han desarrollado una potente herramienta que ya está permitiendo a los científicos extraer características y patrones concretos de una enorme cantidad de datos complejos.

El nuevo algoritmo ha sido ideado por miembros del Lawrence Livermore National Laboratory y es lo suficientemente compacto como para que funcione en un ordenador convencional con una memoria de dos gigabytes.

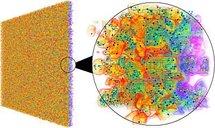

El equipo que ha creado el algoritmo lo ha usado ya para probar una enorme cantidad de fenómenos representados por miles de millones de puntos de datos, incluyendo el análisis y la creación de imágenes de la superficie de una llama. Además, ha sido aplicado para buscar grupos en un experimento de universo virtual, así como para identificar y seguir áreas de fluido en una simulación de mezcla de dos fluidos.

“Lo que hemos desarrollado es un sistema para manejar cualquier dato en cualquier dimensión”, comenta Attila Gyulassy”, que ha liderado esta investigación en los últimos cinco años, en un comunicado. “Esperamos que este algoritmo se convierta en un parte integral de la caja de herramientas de los científicos para dar respuestas sobre datos”.

Los ordenadores son usados habitualmente para llevar a cabo simulaciones de fenómenos del mundo real y para captar resultados de experimentos y observaciones físicas. Además, dichas simulaciones permiten almacenar esta información como colecciones de números.

Ahora bien, al mismo tiempo que el tamaño de estos datos ha crecido (junto a la capacidad de los ordenadores) la dificultad para analizarlos también se ha multiplicado exponencialmente.

40 años de historia

En teoría, desde hace 40 años, existe una herramienta matemática para extraer y visualizar ciertas características de un conjunto de datos. Se llama Morse-Smale, que agrupa grupos de datos por similitudes y los codifica en términos matemáticos. Trabajar con el Morse-Smale no es sencillo. “Es un lenguaje muy potente, pero a costa de que sea muy complicado usarlo en aplicaciones prácticas”, dice Gyulassy.

El algoritmo de Gyulassy divide los conjuntos de datos en parcelas y después analiza cada parcela separadamente usando el sistema Morse-Smale. Los resultados de esos cálculos son posteriormente unidos. Como resultado de esa unión, surgen nuevas parcelas, que vuelven a ser analizadas y unidas de nuevo. En cada uno de esos pasos, los datos que no necesitan ser almacenados son descartados, reduciendo de manera drástica la potencia de computación necesaria para llevar a cabo los cálculos.

Uno de los test hechos para probar este algoritmo consistió en analizar y seguir la formación y el movimiento de áreas de fluidos en una simulación de mezcla de dos fluidos: uno denso y otro ligero. La complejidad de estos datos es enorme (consiste en más de mil millones de puntos de datos en una red tridimensional), incluso para un superordenador. El nuevo algoritmo, sin embargo, ha permitido su análisis en un ordenador portátil convencional con sólo dos gigabytes de memoria.

Aunque Gyulassy tuvo que esperar casi un día para que el ordenador completara los cálculos, al final del proceso pudo obtener imágenes que ilustraban este fenómeno en sólo unos segundos.

Más generación de datos

En la actualidad, son dos los factores que están dirigiendo la necesidad de análisis de grandes conjuntos de datos: por un lado el uso de ordenadores muy potentes que generan muchos datos y, por otro, la mejora de los dispositivos que los investigadores utilizan en el laboratorio para recoger esos datos.

“Los archivos de datos son cada vez más y más grandes, mientras que los científicos tienen cada vez menos tiempo para comprender esos datos”, comenta Bernd Hamann, profesor de informática de la UCD que también ha participado en esta investigación. “Pero, ¿de qué sirven los datos si no tenemos herramientas de computación suficientemente eficientes para buscar en esos datos?

En la actualidad, Gyulassy está desarrollando un software que permitirá a otros usar el nuevo algoritmo. Al ser de código abierto, espera que aumente su nivel de conocimiento.

Los hallazgos de esta investigación fueron publicados en el número de noviembre-diciembre de la revista IEEE Transactions on Visualization and Computer Graphics. Otros autores de ese artículo han sido el profesor de informática Valerio Pascucci, ahora en la Universidad de Utha, y Peer-Timo Bremer, del Lawrence Livermore National Laboratory.

Hacer un comentario